AWS, Microsoft, Google Cloud et Oracle intégreront massivement dans leurs infrastructures les nouvelles plateformes de GPU Blackwell annoncées par Nvidia afin d’offrir à leurs clouds la puissance de traitement de l’IA.

Présentée par Jensen Huang, le CEO de Nvidia lors des conférences GTC, la nouvelle unité de traitement graphique Blackwell fait l’unanimité chez les hyperscalers à la recherche de puissance pour les traitements de l’IA.

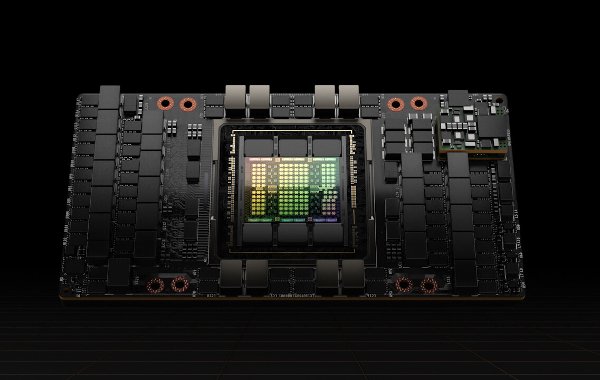

Nvidia a présenté les GPU Blackwell B200 et Grace Hopper GH200, ce dernier étant surnommé « superpuce », les processeurs qui succèdent aux séries Hopper H100 et H200, les puces les plus demandées pour les opérations de calcul de l’IA.

Pour Nvidia, Rockwell n’est plus un GPU (unité de traitement graphique), mais une plateforme reposant sur une architecture de processeur pouvant embarquer jusqu’à 576 GPU ! On comprend l’intérêt des hyperscalers, à la recherche de puissance et de réduction d’échelle pour faire plus avec moins, pour ces infrastructures d’IA.

- AWS intégrera Rockwell dans les instances EC2 pour accélérer la création et l’inférence de LLM de plusieurs milliards de paramètres.

- Microsoft intégrera les GPU Rockwell et des microservices d’inférence NIM de Nvidia sur Azure, Fabric et 365 .

- Google Cloud intégrera la plate-forme Grace Blackwell AI et le service Nvidia DGX Cloud.

- Oracle intégrera Rockwell sur son infrastructure cloud OCI .