CPU et GPU explosent la consommation énergétique des serveurs, pas toujours à bon escient. Les processeurs d’Ampere Computing offrent une alternative dont la puissance n’a pas à rougir face aux CPU X86, mais dans une enveloppe électrique donc thermique réduite. Jeff Wittich, Chief Product Officer chez Ampere Computing, a joué au jeu des 3 questions avec DCmag.

La technologie Ampere se distingue par une meilleure efficacité énergétique. Quelles en sont les mesures et dans quelles conditions d’usages et configurations dans les data centers ?

Avec l’essor de l’IA et des processeurs gourmands en énergie qui l’accompagnent, l’industrie est confrontée à une crise de capacité. L’infrastructure des serveurs, qui a généralement plus de 5 ans, vieillit et elle est vulnérable. Et entre ces serveurs obsolètes et l’ajout de GPU de 1 kW , les datacenters sont à moitié vidés en raison du manque d’électricité.

Les performances par watt, qui constituaient autrefois la mesure courante des performances des datacenters, supposent implicitement une puissance illimitée. Dans ce nouvel environnement où l’énergie est limitée , les performances par rack sont devenues la nouvelle norme. Mais 83 % des datacenters disposent de moins de 20 kW de puissance disponible…

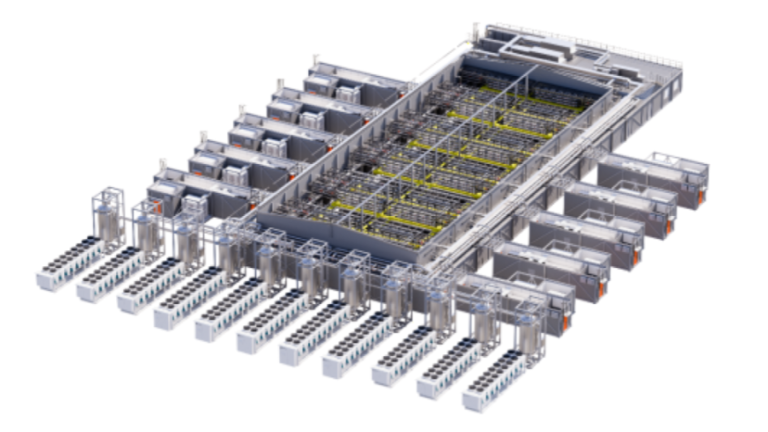

Pour les clients qui souhaitent développer leur activité, intégrer davantage de puissance de calcul dans leur espace de stockage et de données existant est devenu le nouvel argument de valeur, et c’est pourquoi ils se tournent vers Ampere. Plutôt que de supporter les dépenses liées à la construction de nouveaux datacenters, ils choisissent de moderniser leur infrastructure avec les processeurs hautes performances et basse consommation d’Ampere.

Lors de la mise à niveau des systèmes existants avec des processeurs de dernière génération, Ampere offre des performances par rack de premier ordre par rapport aux alternatives x86. En fait, pour certaines charges de travail Cloud Native, Ampere offre jusqu’à 58 % de performances en plus par rack par rapport à la concurrence. Cela permet aux clients de maximiser l’espace actuellement vide et de le consacrer à de nouvelles innovations, notamment l’IA.

Quels sont les pratiques et outils proposés par Ampere pour accompagner, faciliter, voire automatiser l’adoption et la gestion de ses CPU ?

Ampere propose deux services principaux pour aider les clients à réduire les risques et à accélérer l’adoption de ses processeurs Cloud Native. Le premier est AmpereOne Design Services, grâce auquel notre équipe de plateforme analyse les schémas et les mises en page pour vérifier leur conformité. Le deuxième est AmpereOne Software Services, qui propose des conseils de notre équipe d’ingénierie pour garantir des performances optimales.

Outre ces services, nous mettons à la disposition de nos clients et partenaires un certain nombre d’outils en libre-service. Nous disposons de bibliothèques de logiciels compatibles Ampere disponibles sur notre site Web , le Porting Advisor d’Ampere signale les domaines qui doivent être optimisés lors de la migration depuis x86, et notre outil APKB aide les clients à évaluer, mesurer et planifier la mise à jour de leur infrastructure existante.

L’un de nos outils dont nous sommes particulièrement fiers est Ampere AIO, qui aide les clients à obtenir des performances supérieures pour les charges de travail d’IA en intégrant des couches d’inférence optimisées dans des frameworks d’IA courants. Notre pile logicielle mappe les frameworks de développement d’IA populaires, tels que TensorFlow, PyTorch et ONNX-RT, sur l’architecture Cloud Native d’Ampere pour atteindre le plus haut niveau d’efficacité opérationnelle et de vitesse d’exécution.

Le marché, sous l’influence de l’IA, est très orienté vers les GPU. Comment et dans quelles infrastructures de data center les CPU peuvent-ils répondre à une partie des attentes liées aux GPU ?

Le marché de l’IA est aujourd’hui très axé sur les GPU, mais ils sont trop puissants pour la majorité des charges de travail de l’IA. Les GPU sont utiles pour l’entraînement de l’IA, mais la réalité est que 85 % du silicium de l’IA est en fait utilisé pour l’inférence. Nous pensons que ces 85 % peuvent et doivent être gérés par des processeurs – soit des processeurs Ampere avec notre outil AIO, soit des processeurs Ampere avec des accélérateurs spécifiques au domaine en fonction du cas d’utilisation.

Cette approche présente de nombreux avantages. Par exemple, les données de performances montrent que l’exécution de Llama 3 sur le processeur Ampere Altra à 128 cœurs sans GPU offre les mêmes performances qu’un GPU Nvidia A10 associé à un processeur x86, tout en utilisant un tiers de la puissance. Pour des charges de travail d’inférence comme celle -ci, utiliser un GPU revient à conduire une Ferrari gourmande en carburant pour votre trajet le matin : c’est plus que ce dont vous avez besoin.