Votre datacenter déménage… en périphérie – Cinq impératifs de réseau à prendre en compte, avant le grand déménagement

Par Vincent Blavet, Responsable Avant-Vente, Aruba, une soéciété de Hewlet Packard Entreprise

Dans un avenir proche, on estime que la moitié de toutes les données que nous créons en tant que société seront traitées à la périphérie, près du point où elles sont produites pour la collecte et l’analyse. Le datacenter restera une pièce essentielle de l’infrastructure informatique, mais son rôle se transformera pour soutenir des sites distants en évolution rapide avec des ressources informatiques complètes de calcul, de stockage et de réseau.

Les datacenters d’entreprise traditionnels seront complétés par des versions distribuées et virtualisées, pour se rapprocher des lieux où les données sont collectées : les clouds publics et un nombre croissant de foyers de données à la périphérie. Cette répartition de la collecte et de l’analyse des données signale un déplacement des datacenters vers des centres de données, en modifiant les infrastructures et les stratégies opérationnelles en cours de route.

L’un des catalyseurs de cette évolution est le changement de la nature des données. Par exemple, le nombre de caméras connectées va doubler au cours des cinq prochaines années, chacune d’entre elles produisant d’énormes quantités d’informations. Les trois quarts des points d’extrémité du réseau sont déjà des dispositifs IoT. Pendant ce temps, les applications d’entreprise traditionnelles et l’exploitation des usines se déplacent vers l’infrastructure commune. De plus en plus, les décisions et les actions en temps réel seront nécessaires à mesure que le nombre d’équipements et d’infrastructures d’usines connectés augmentera.

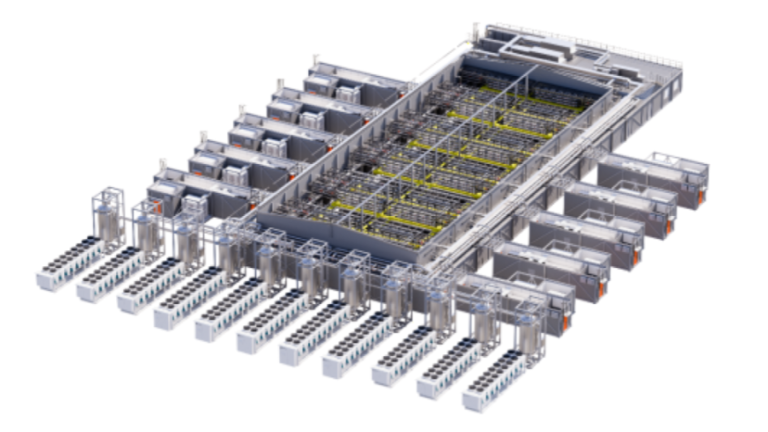

Prenons par exemple les processus de fabrication modernes à haut débit avec vidéo et capteurs pour garantir une qualité et une sécurité accrues. Dans l’industrie pétrolière et gazière, la détection des fuites et les dysfonctionnements des équipements sont désormais étroitement surveillés et rapidement corrigés grâce à des systèmes distribués automatisés. Dans le secteur public, les villes intelligentes s’appuieront sur des caméras, des capteurs et d’autres dispositifs IoT pour surveiller la sécurité publique, optimiser le trafic, entretenir les infrastructures et promouvoir l’efficacité énergétique.

Dans tous les secteurs, une variété d’infrastructures (calculs/GPU, VM, applications de conteneurisation, stockage) et de dispositifs de réseau (sans fil, filaire, WAN) seront nécessaires pour répondre à ces exigences à la périphérie.

Selon IDC, d’ici 2023, plus de 50 % des nouvelles infrastructures informatiques des entreprises seront affectées à des environnements périphériques, qui devront être connectés de manière fiable et sûre aux datacenters et aux réseaux cloud.

Mais si beaucoup d’entreprises prendront ce virage, certaines se retrouveront mal préparées. Un nombre croissant de périphéries d’entreprise sont construites sur des systèmes de calcul et de stockage cloisonnés, avec des architectures de réseau séparées non seulement sur site, dans le datacenter ou la succursale, mais aussi sur les sites périphériques émergents. Avec cette explosion des centres de données, il est difficile, voire impossible de monter en puissance en utilisant des approches traditionnelles.

Les datacenters traditionnels doivent être repensés et redessinés pour tenir compte des nouveaux centres de données distribués et périphériques.

Voici cinq recommandations pour accompagner cette transition :

Unifier l’infrastructure – il faut concevoir une infrastructure réseau et un modèle d’exploitation unifiés, gérés dans le cloud, pour l’ensemble de l’entreprise étendue (campus, succursales et centres de données traditionnels et émergents). Il est beaucoup plus facile de gérer une architecture de réseau d’entreprise en expansion qui repose sur un modèle d’exploitation commun (système d’exploitation, fonctionnalités et outils niveaux 2/3) que d’essayer de gérer différentes architectures dans les différents domaines de l’entreprise.

Adopter l’automatisation – il faut mettre en œuvre un réseau piloté par l’intelligence artificielle et définie par logiciel pour aider à automatiser les tâches manuelles, habituelles et complexes souvent associées à la mise en réseau. Les AIOps émergents peuvent accélérer cette transformation en combinant l’identification des problèmes par l’IA avec l’automatisation pour garantir le plus haut degré de disponibilité et de performance du réseau. Certaines solutions s’intègrent également directement dans les ressources de calcul, de stockage et de gestion de la virtualisation déjà utilisées pour fournir une infrastructure informatique encore plus rationnelle.

Déployer des solutions intégrées – alors que certaines organisations peuvent avoir le temps, l’énergie et l’expertise interne nécessaires pour concevoir et intégrer des solutions informatiques personnalisées, de nombreux fournisseurs proposent des solutions prêtes à l’emploi, optimisées en fonction de la charge de travail, et qui simplifient et accélèrent la fourniture de services informatiques tout en réduisant le temps, les risques et l’expertise nécessaires pour déployer des solutions complexes. Il faut rechercher des solutions intégrant le réseau dans les ressources, plutôt que de l’aborder a posteriori. Par exemple, les solutions hyperconvergentes intègrent à la fois les réseaux physiques et virtuels.

Mettre en place une sécurité Zero Trust – la sécurité doit être au premier plan de toute discussion sur l’architecture. La clé est de construire la sécurité à partir de zéro et de l’étendre à tous les domaines du réseau. Par défaut, les réseaux Zero Trust permettent :

- L’authentification de chaque utilisateur, appareil, flux et « chose » sur le réseau.

- La création centralisée de politiques basées sur les rôles et la mise en œuvre de tous les aspects de l’Intelligent Edge, du datacenter central à chaque point périphérique et chaque appareil IoT.

- La segmentation dynamique des utilisateurs, des appareils, des invités et de leur trafic, quel que soit l’endroit où ils se connectent au réseau et la manière dont ils l’utilisent.

Appuyer sur le bouton « Facile » – la montée en puissance se fera à travers le cloud avec une facturation en fonction de l’utilisation. Il y a une grande marge de manœuvre. Il faut trouver un équilibre entre toutes les technologies de l’information sur site, le passage au cloud et des points de connexion périphériques en expansion. Orchestrer (et payer) ce cette complexité peut être intimidant.

La bonne nouvelle, c’est que les entreprises disposent de nouvelles options pour les services cloud et d’une infrastructure « as a service » pour leurs charges de travail – sur site, entièrement gérée selon un modèle de paiement à l’utilisation. Les entreprises devraient sérieusement envisager et évaluer ces possibilités afin d’accroître leur efficacité, de progresser plus rapidement et d’obtenir de meilleurs résultats commerciaux.