Le concepteur de puces pour l’IA de la ,taille d’un wafer Cerebras Systems déploie des data centers d’inférence aux Etats-Unis et en Europe.

Après les infrastructures massives d’apprentissage et de LLM (langages) qui servent de base à l’IA générative, et qui font l’objet d’investissements considérables, d’autres acteurs du marché se positionnent pour supporter la prochaine vague de l’IA, l’inférence. Autrement dit des infrastructures d’usage de l’IA.

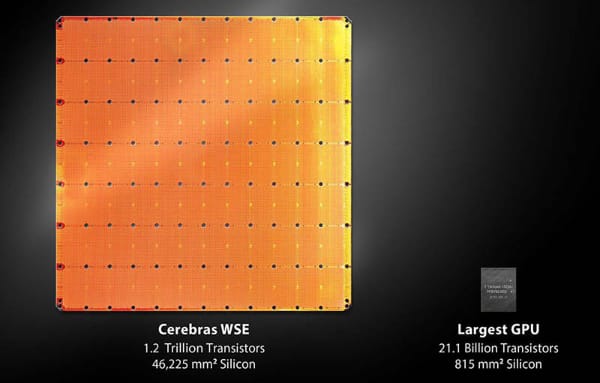

Cerebras Systems développe une plateforme d’inférence d’IA ultra rapide, qui repose sur un wafer (la galette sur laquelle sont ‘imprimés’ les transistors des processeurs) sur lequel s’exécutent en parallèle et à très grande échelle les requêtes d’IA. Cette technologie prend le nom de Wafer Scale Engine 3, elle s’appuie sur 4 milliards de transistors, 900 000 cœurs d’IA et surtout 44 Go de SRAM.

Elle ne nous est pas inconnue, c’est cette technologie qui permet l’exécution instantanée d’une invite de code de Mistral Le Chat sur le modèle Mistral Large 2 à 123 milliards de paramètres.

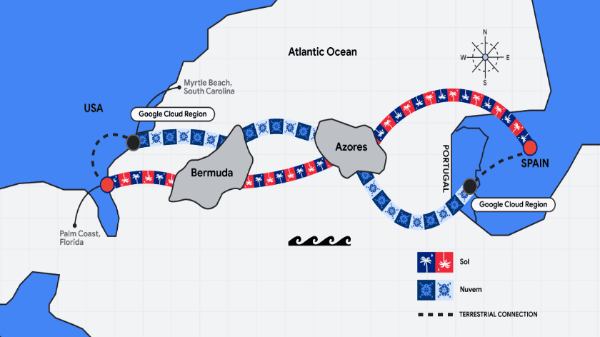

Pour répondre aux besoins des applications d’IA générative, Cerebras ambitionne de créer un grand cloud d’inférence haut débit national américain, et de s’étendre en Europe, certainement pour accompagner les projets de Mistral AI.

Ce déploiement repose sur des data centers, ou plutôt sur l’hébergement des Wafer Scale Engine 3 dans des data centers de colocation. Déjà trois data centers d’inférence d’IA sont opérationnels aux Etats-Unis, à Santa Clara et Stockton (Californie), et à Dallas (Texas).

L’infrastructure Cerebras va continuer de s’étendre avec six nouvelles implantations dans des datacenters, programmées pour 2025 : Minneapolis, Oklahoma City, Montréal, le Midwest et l’Est des États-Unis, et en Europe.

Remarque : chez Cerebras, l’infrastructure d’inférence est qualifiée de ‘souveraine’. La notion de souveraineté prend des attributs bien différents selon le côté de l’Atlantique ou l’on se trouve !