Le nouveau supercalculateur d’IA, le plus grand du cloud, pourra atteindre jusqu’à 131 072 GPU NVIDIA afin de permettre aux clients de créer des IA, de les entraîner et de réaliser des inférences à grande échelle.

Communiqué – Oracle a annoncé ses premiers clusters de cloud computing zettascale accélérés par la plateforme NVIDIA Blackwell. Oracle Cloud Infrastructure (OCI) accepte désormais les commandes pour le plus grand superordinateur d’IA dans le cloud, disponible avec jusqu’à 131 072 GPU NVIDIA Blackwell.

« Nous disposons de l’une des offres d’infrastructure d’IA les plus étendues et prenons en charge les clients qui exécutent certains des workloads d’IA les plus exigeants dans le cloud », explique Mahesh Thiagarajan, executive vice president, Oracle Cloud Infrastructure. « Avec le cloud distribué d’Oracle, les clients ont la flexibilité de déployer des services cloud et d’IA où qu’ils se trouvent, tout en préservant les plus hauts niveaux de souveraineté des données et de l’IA. »

Premier cluster de calcul zettascale au monde

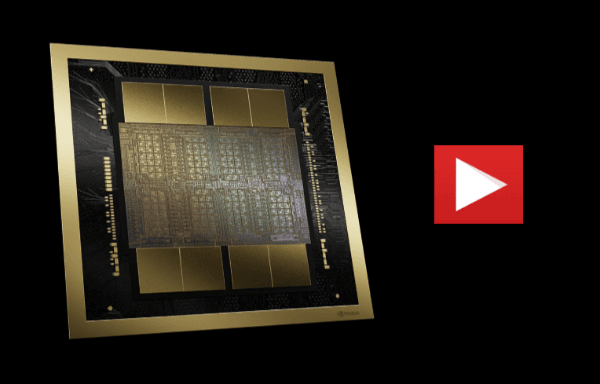

OCI accepte désormais les commandes pour le plus grand supercalculateur d’IA dans le cloud, qui peut atteindre jusqu’à 131 072 GPU NVIDIA Blackwell avec à la clé une performance sans précédent de 2,4 zettaFLOPS. L’échelle maximale d’OCI Supercluster offre plus de trois fois plus de GPU que le superordinateur Frontier et plus de six fois d’autres hyperscalers. OCI Supercluster inclut OCI Compute Bare Metal, une latence ultra-faible RoCEv2 avec des cartes d’interface réseau ConnectX-7 et ConnectX-8 SuperNICs ou la plate-forme réseau NVIDIA Quantum-2 InfiniBand, ainsi qu’un choix de stockage HPC.

Les superclusters OCI peuvent être commandés avec OCI Compute optimisé par des GPU NVIDIA H100 ou Tensor Core H200 ou NVIDIA Blackwell. Les superclusters OCI avec des GPU H100 peuvent atteindre 16 384 GPU avec jusqu’à 65 ExaFLOPS de performances et 13 Po/s de débit réseau agrégé. Les superclusters OCI avec des GPU H200 atteindront 65 536 GPU avec jusqu’à 260 ExaFLOPS de performances et 52 Po/s de débit réseau agrégé et seront disponibles plus tard cette année.

Les superclusters OCI dotés d’instances bare metal refroidies par liquide NVIDIA GB200 NVL72 utiliseront NVLink et les commutateurs NVLink pour permettre à jusqu’à 72 GPU Blackwell de communiquer entre eux avec une bande passante agrégée de 129,6 To/s dans un domaine NVLink unique. Les GPU NVIDIA Blackwell, disponibles au premier semestre 2025, avec NVLink de cinquième génération, le commutateur NVLink et la mise en réseau de cluster, permettront une communication transparente de GPU à GPU au sein d’un seul cluster.

« À l’heure où les entreprises, les chercheurs et les pays tentent d’innover en utilisant l’IA, l’accès à de puissants clusters informatiques et à des logiciels d’IA se révèle essentiel », constate Ian Buck, vice president of Hyperscale and High Performance Computing, NVIDIA. « La plateforme de calcul d’IA full-stack de NVIDIA sur le cloud distribué d’Oracle fournira des capacités de calcul d’IA à une échelle sans précédent pour faire progresser les efforts d’IA à l’échelle mondiale et aider les entreprises du monde entier à accélérer la recherche, le développement et le déploiement. »

Des clients tels que WideLabs et Zoom tirent parti de l’infrastructure d’IA hautement performante d’OCI avec de puissants contrôles de sécurité et de souveraineté.

WideLabs entraîne l’un des plus grands LLM pour le portugais sur OCI

WideLabs, une start-up brésilienne d’IA appliquée, entraîne Amazonia IA, l’un des plus grands LLM (Large Language Model) du Brésil, sur OCI. Elle a développé bAIgrapher, une application qui utilise son LLM pour générer du contenu biographique à partir de données recueillies auprès de patients atteints par la maladie d’Alzheimer pour les aider à préserver leurs souvenirs les plus précieux.

WideLabs utilise la région Oracle Cloud de São Paulo pour exécuter ses workloads d’IA, garantissant ainsi que les données sensibles restent à l’intérieur des frontières du pays. Cette approche permet à WideLabs de respecter la législation brésilienne en matière de souveraineté de l’IA en étant en mesure de contrôler où sa technologie d’IA est déployée et exploitée.

WideLabs utilise l’infrastructure d’IA OCI avec des GPU NVIDIA H100 pour entraîner ses LLM, ainsi qu’Oracle Kubernetes Engine pour provisionner, gérer et utiliser des conteneurs accélérés par GPU dans un supercluster OCI composé d’OCI Compute connecté au réseau de cluster basé sur RMDA d’OCI.

« L’infrastructure d’OCI AI nous offre la plus grande efficacité pour l’entraînement et l’exécution de nos LLM », explique Nelson Leoni, CEO de WideLabs. « L’échelle et la flexibilité d’OCI s’avèrent incroyablement utiles, à mesure que nous continuons d’innover dans le domaine des soins de santé et dans d’autres secteurs clés. »

Zoom utilise les fonctionnalités de souveraineté d’OCI pour son assistant d’IA générative

Zoom, l’une des meilleures plateformes de collaboration axées sur l’IA, utilise OCI pour fournir des inférences à Zoom AI Companion, l’assistant personnel d’IA de l’entreprise disponible sans frais supplémentaires. Zoom AI Companion aide les utilisateurs en rédigeant des e-mails et des messages, résumant des réunions et des fils de discussion, générant des idées lors de brainstorms avec des collègues, etc. Les fonctionnalités de souveraineté des données et de l’IA d’OCI aideront Zoom à conserver les données client localement dans la région et à prendre en charge les exigences de souveraineté de l’IA en Arabie saoudite, où la solution d’OCI est déployée initialement.

« Zoom AI Companion révolutionne le fonctionnement des entreprises, avec des fonctionnalités d’IA générative à la pointe, disponibles sans frais supplémentaires avec les comptes payants des clients », explique Bo Yan, head of AI, Zoom. « En exploitant les fonctionnalités d’inférence pour l’IA d’OCI, Zoom est en mesure de fournir des résultats précis avec une faible latence, ce qui permet aux utilisateurs de collaborer aisément, de communiquer sans effort et d’atteindre un niveau inégalé de productivité, d’efficacité et de potentiel. »