On considère traditionnellement qu’assurer le bon fonctionnement d’un environnement entreprise est plus complexe et demande plus d’efforts que pour un environnement cloud à cause de la diversité des applications et de l’hétérogénéité des générations de matériels. Les infrastructures de l’enseignement supérieur sont encore plus exigeantes.

Par Mike Bushong, vice-président Group Cloud-Ready Data Center chez Juniper Networks

Imaginez toutes les subtilités d’une infrastructure distribuée qui sous-tend l’activité de nombreux services répartis dans des dizaines de bâtiments, qui eux-mêmes abritent des milliers d’étudiants. Tout cela doit bien-sûr être géré avec des ressources humaines notoirement insuffisantes. Heureusement, le véritable attrait pour les technologies du personnel des universités les aide à être plus efficace que des équipes comparables dans le milieu entreprise et la pause estivale donne souvent juste assez de répit pour faire évoluer l’infrastructure et se préparer tant bien que mal au prochain assaut d’étudiants.

L’enseignement supérieur à l’avant-garde de l’adoption des dernières technologies réseaux

À bien des égards, les réseaux de l’enseignement supérieur ont servi de modèles aux autres secteurs d’activités pour définir leurs bonnes pratiques. Les réseaux de recherche sont en effet souvent parmi les premiers à tester les nouvelles technologies, en particulier celles qui facilitent le partage à haut débit nécessaire à la collaboration à distance. En effet, les 100 Gbit/s, 400 Gbit/s et maintenant 800 Gbit/s et au-delà ont tous trouvé leur place dans les grands réseaux de recherche, soutenant souvent des projets de clusters de calcul haute performance.

Mais à mesure que l’industrie commence à passer des réseaux purs (connexion des applications et des utilisateurs) à la mise en réseau, c’est-à-dire l’administration de ces derniers, les technologies vont aller au-delà du simple transport de données pour s’étendre naturellement vers la gestion des opérations. Là encore, les établissements d’enseignement supérieur ont depuis longtemps devancé les entreprises. Dotées d’administrateurs Unix capables d’automatiser leurs tâches quotidiennes, les universités utilisent depuis des années les concepts d’infrastructures réseaux programmables. Cependant, alors que de plus en plus d’outils d’entreprise et cloud arrivent sur le marché, cette approche artisanale devrait naturellement se compléter d’outils prêts à l’emploi, ce qui permettra à ces équipes disposant de peu de personnel d’aller encore plus loin.

Pour une équipe habituée à gérer dans le détail l’infrastructure en ligne de commande, certaines des fonctionnalités de pointe peuvent sembler un peu inaccessibles. Pour tirer parti des outils de gestion de réseau modernes et simplifiés, il convient de savoir s’extraire des interfaces techniques pour opérer à un niveau plus abstrait et moins détaillé. Le compromis pour une complexité réduite est malheureusement souvent un contrôle moins fin, ce qui peut être difficile à accepter lorsque vous considérez les nombreux besoins d’une université multisites. Mais c’est ici ce qui est nécessaire pour libérer le temps précieux pour avancer sur le prochain projet d’envergure.

S’il y a bien un avantage que les universités peuvent retirer de l’usage d’architectures pensées pour le cloud, c’est l’abandon du sur-mesure en faveur d’architectures réseau standardisées.

Cette transition a certainement été le changement le plus important de la dernière décennie. L’uniformité de la conception a facilité les déploiements et cette couche d’infrastructure commune a permis des avancées majeures dans l’automatisation et les opérations.

La nécessité d’aller au-delà de la connectivité

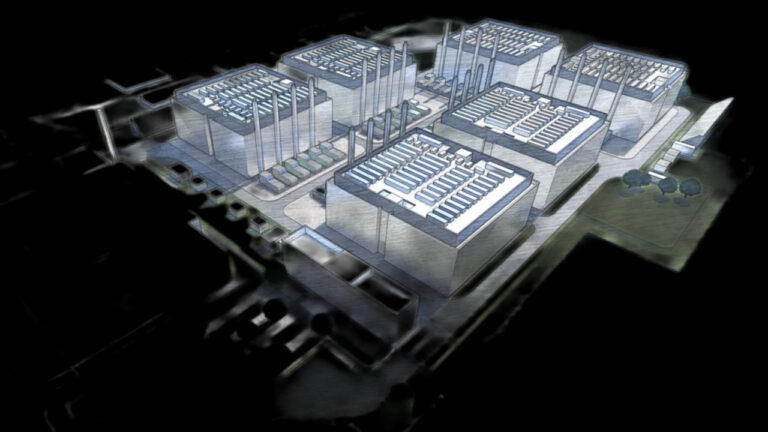

Les salles de cours, les laboratoires les résidences universitaires et les services administratifs d’une grande université continueront d’avoir des besoins dictés par la diversité de leurs utilisateurs. Par conséquent, pour que le service informatique progresse vers une expérience plus uniforme, il est logique de commencer par le datacenter. En y important les principes du cloud public, les équipes informatiques pourront tirer parti des dernières technologies pour accélérer les opérations et répondre aux exigences des utilisateurs. Répondre rapidement à cette attente, libèrera des ressources et enclenchera un cercle vertueux de transformations.

Mais l’avenir de l’informatique dans le secteur ne se limite pas à la simple recherche de petits gains d’efficacité. Le véritable but pour les équipes informatiques du monde entier doit aller au-delà de la connectivité. L’expérience utilisateur et applicatif est le nouveau graal. Il ne suffit plus de dire que quelque chose est en cours d’exécution mais de comprendre si l’expérience de l’utilisateur final est ce qu’elle devrait être. Et si ce n’est pas le cas, pourquoi.

Répondre à ces questions pousse les opérations bien au-delà de la fourniture de service et de sa réparation. Cela nécessite un autre type d’indicateurs, qui ne vise pas tant à vérifier la connectivité qu’à examiner la qualité globale de l’expérience. Il faut avoir une vue en temps réel de ce qui se passe sur le réseau et de son impact sur les utilisateurs. Un portefeuille d’outils développé avec le provisionnement à l’esprit élèvera naturellement l’interface au rôle principal. Mais si l’expérience utilisateur prime, la capacite à la dériver des évènements réseau doit devenir le facteur le plus important. Le cahier des charges des outils d’exploitation est fondamentalement différent. Il s’agit moins de se concentrer sur les flux de travail que sur la collecte d’informations diverses à partir des infrastructures.

Ce sont ces informations qui permettront en fin de compte d’offrir une meilleure expérience utilisateur. La question que doivent se poser les universités qui s’engagent dans cette direction est de savoir par où commencer. Et compte tenu des progrès réalisés dans l’exploitation des datacenters au cours des cinq à sept dernières années, la réponse pourrait bien finalement se trouver dans ces mêmes datacenters.