Le Consumer Electronics Show (CES) 2026, qui s’est tenu à Las Vegas, a marqué un tournant dans l’évolution de l’intelligence artificielle, le Physical AI (Intelligence Artificielle Physique), une nouvelle ère de l’IA qui ne se contente plus de générer du texte, de la voix ou des recommandations, mais interagit physiquement avec le monde.

Après des années de domination de l’IA logicielle — modèles générant du texte, des images ou des recommandations — l’accent se déplace vers ce que l’industrie appelle désormais le « Physical AI » (intelligence artificielle physique), une classe de technologies qui intègre des capacités cognitives avancées dans des systèmes capables de percevoir, réfléchir et agir dans le monde réel.

Qu’est-ce que le Physical AI ?

Traditionnellement, l’intelligence artificielle fonctionne dans des environnements numériques. Le Physical AI fusionne cette intelligence logicielle avec des capteurs, actionneurs, contrôleurs matériels et réseaux embarqués afin de créer des machines qui peuvent :

- percevoir leur environnement via des capteurs (caméras, lidar, microphones, capteurs tactiles),

- décider de l’action à entreprendre à partir de ces perceptions,

- exécuter des actions physiques à l’aide de moteurs ou d’actionneurs

- apprendre et s’adapter à partir de leurs expériences réelles.

Contrairement aux systèmes préprogrammés, ces agents intelligents construisent leur comportement à partir de l’interaction dynamique avec leur contexte — une transformation considérable qui dépasse les chaînon manquants des applications pilotées par écran.

Les tendances clefs révélées à CES 2026

- Robots humanoïdes et assistants autonomes

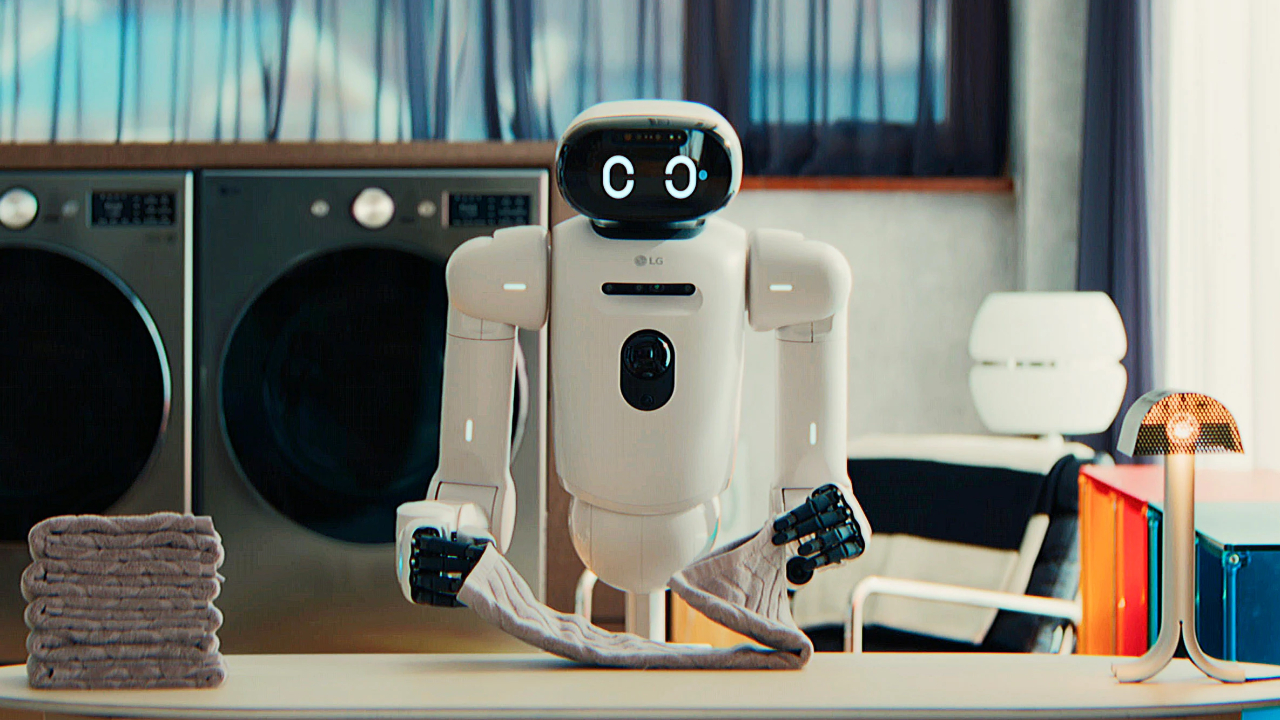

L’un des moments forts du salon fut la présentation de robots humanoïdes avancés. Hyundai Motor Group, via sa filiale Boston Dynamics, a dévoilé une version entièrement électrique de son robot Atlas, avec des capacités de mouvement plus précises et des algorithmes d’apprentissage par renforcement capables d’adapter ses actions en temps réel.

Ces robots ne sont plus de simples prototypes de laboratoires : ils intègrent des moteurs électriques avancés, des contrôleurs d’IA embarqués et une architecture logicielle qui leur permet de s’adapter à des tâches diverses — un signal que l’industrie considère comme un passage crucial vers une robotique opérant réellement dans le monde physique.

- L’écosystème logiciel et matériel évolue vers l’intégration complète

Des concepteurs de puces comme Arm et NVIDIA ont structuré leurs activités autour du Physical AI. Arm a annoncé une ligne dédiée à cette discipline, signalant que les systèmes embarqués intelligents sont désormais un élément de croissance stratégique. NVIDIA a de son côté mis en avant des plateformes logicielle et matérielle qui simplifient le passage de la simulation à la réalité (sim2real), un défi majeur pour déployer des agents intelligents en conditions réelles.

Cette évolution va au-delà de l’innovation isolée : elle reflète le fait que l’IA n’est plus seulement une fonction logicielle déportée vers le cloud, mais une capacité intégrée directement dans les dispositifs physiques, capables d’apprendre, interagir et réagir sans latence ni dépendance réseau.

- Usages industriels, domestiques et grand public

À CES 2026, les applications en démonstration allaient des robots industriels aux assistants domestiques. LG Electronics a présenté CLOiD, un robot domestique capable d’exécuter des tâches ménagères tout en servant d’assistant intelligent pour gérer d’autres appareils connectés. Doosan Robotics a remporté des prix pour des systèmes combinant bras robotisés et robots mobiles autonomes capables d’inspecter ou d’optimiser des opérations complexes.

Ces exemples montrent comment le Physical AI s’étend de secteurs traditionnels comme la fabrication vers des environnements plus variés où l’adaptabilité est primordiale. Le robot d’IA physique, humanoïde et autonome devient réalité.